2024-02-13

Tech

AI

日本語ローカル LLM 「ELYZA」と vLLM を試す

前回の 【悲報】日本語ローカル LLM がアホすぎる件 から次のことを試した。

- 一番頭のいいモデルである Swallow-70b-hf を試す

- elyza/ELYZA-japanese-Llama-2-13b-fast-instruct を試す

- vLLM を試す

Swallow-70b-hf

自分の GPU (GeForce GTX 1080 Ti) では重すぎて1時間待っても3文字くらいしか応答がなかった。 ちょっと実用性がないので採用を諦めた。

ELYZA-japanese-Llama-2-13b-fast-instruct

Swallow は前回かなり残念な感じだったので別のモデルを試すことにした。 そこで ELYZA 社の上記のモデル。

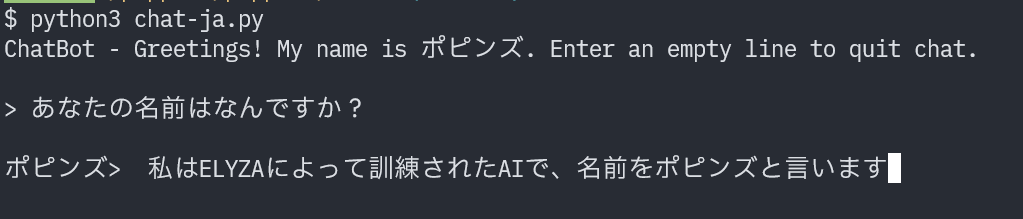

まともな回答してる!

これだよ、これ!!

前回の Swallow は何だったのかと思うほどきちんとした回答が返ってきた。 応答速度も数分かかるものの許容範囲レベル。 ひとまずモデルとしては ELYZA-japanese-Llama-2-13b-fast-instruct で決定することにした。

vLLM による高速化

vLLM はローカル LLM を高速化できるライブラリ。

vllm/vllm-openai という Docker イメージがあるので試しに使ってみたが、 GPU メモリーリークを起こして動かなかった。 自分の GPU が貧弱なためか、設定を変える必要があるのかいまいちよくわからない。

ノート PC の GPU でもメモリーリークしたので多分設定を変える必要がある。

引き続き試すとして、一旦は llama-cpp-python で動かすことにする。

一覧に戻る