2024-02-25

Tech

AI

ローカル LLM を自宅サーバーで動かして Chatbot を作る

今までローカル LLM を色々と試してきたわけだが、ついに集大成として Chatbot を作るに至った。

結局、結論としては、

- モデル:

elyza/ELYZA-japanese-Llama-2-13b-fast-instruct

を使う

- 正確には GGUF がほしいので

こちら

の

ELYZA-japanese-Llama-2-13b-fast-instruct-q4_K_S.ggufを使うことにした

- 正確には GGUF がほしいので

こちら

の

- サーバー: llama-cpp-python を docker で動かす。

- クライアント: nlux というのが React で動くチャットボットの UI をすぐに作れるので採用した

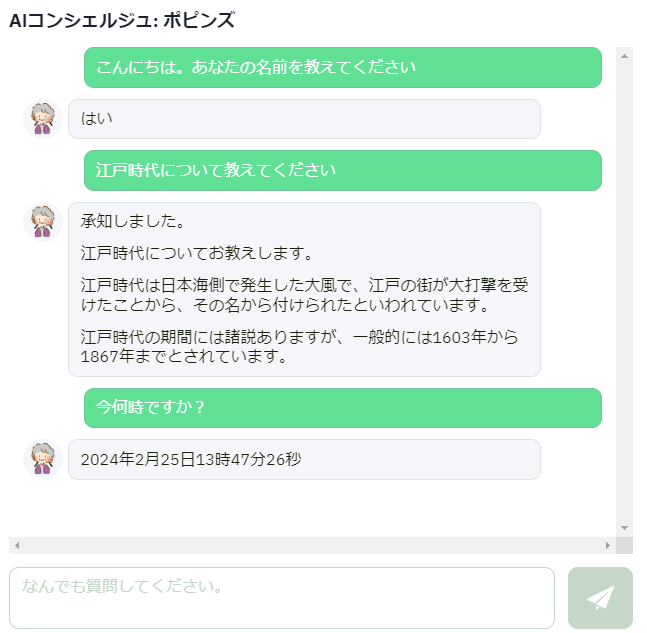

動かしてみる

そこそこまともに回答してくれる。

ソースコードサンプル

そのうち作る。

一覧に戻る